一、ollama是什么?

在本地启动并运行大型语言模型。运行Llama 3,Mistral, Gemma, Code Llama和其他模型。自定义并创建您自己的。

优势如下:

- 快速下载+容器自动运行大模型,现在下载,马上上手。

- 本地利用 cpu 运行大模型,本地安全可靠。

- ollama 命令,管理大模型相对方便,也可以多个大模型中切换。

- 终端直接开始聊天。

- 社区提供了支持 web api 方式访问 WebUI。

官方网站: Ollama

github :https://github.com/ollama/ollama

二、准备和安装工作

设备需求和辅助软件:

- Ollama自带docker ,为了方便部署软件。

- 良好的网络环境,大模型还是要先下载下来的。

- 配置要求:一般来说参数越大,需要配置越好。

- 存储空间:确保硬盘空间充足,并且学会设置环境变量来调整保存model的地址,别再下载到C盘了!

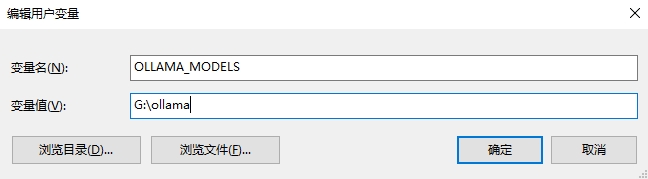

model地址和环境变量设置

win10 设置系统环境变量:OLLAMA_MODELS,值设置本地路径,找个盘空间大点的

下载ollama

官方网站: Ollama

进入 ollama 下载页面,选择自己的系统版本的下载并安装即可。

检验是否安装成功

打开cmd命令窗口,输入ollama

Microsoft Windows [版本 10.0.19045.4291]

(c) Microsoft Corporation。保留所有权利。

C:\Users\hcq>ollama

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

C:\Users\hcq>

三、ollama 模型库

详见library (https://ollama.com),用于搜索已收录的模型库。以下是一些流行的模型:

| 模型 | 参数 | 尺寸 | 执行下载 |

|---|---|---|---|

| Llama3 8B | 8B | 4.7GB | ollama run llama3:8b |

| Llama3 70B | 70B | 40GB | ollama run llama3:70b |

| Mistral | 7B | 26GB | ollama run mistral |

| Code Llama 7b | 7B | 3.8GB | ollama run codellama:7b |

| Code Llama 13b | 13B | 7.4GB | ollama run codellama:13b |

| Code Llama 34b | 34B | 19GB | ollama run codellama:34b |

| Code Llama 70b | 70B | 39GB | ollama run codellama:70b |

| Gemma | 2B | 1.7GB | ollama run gemma:2b |

| Gemma | 7B | 5GB | ollama run gemma:7b |

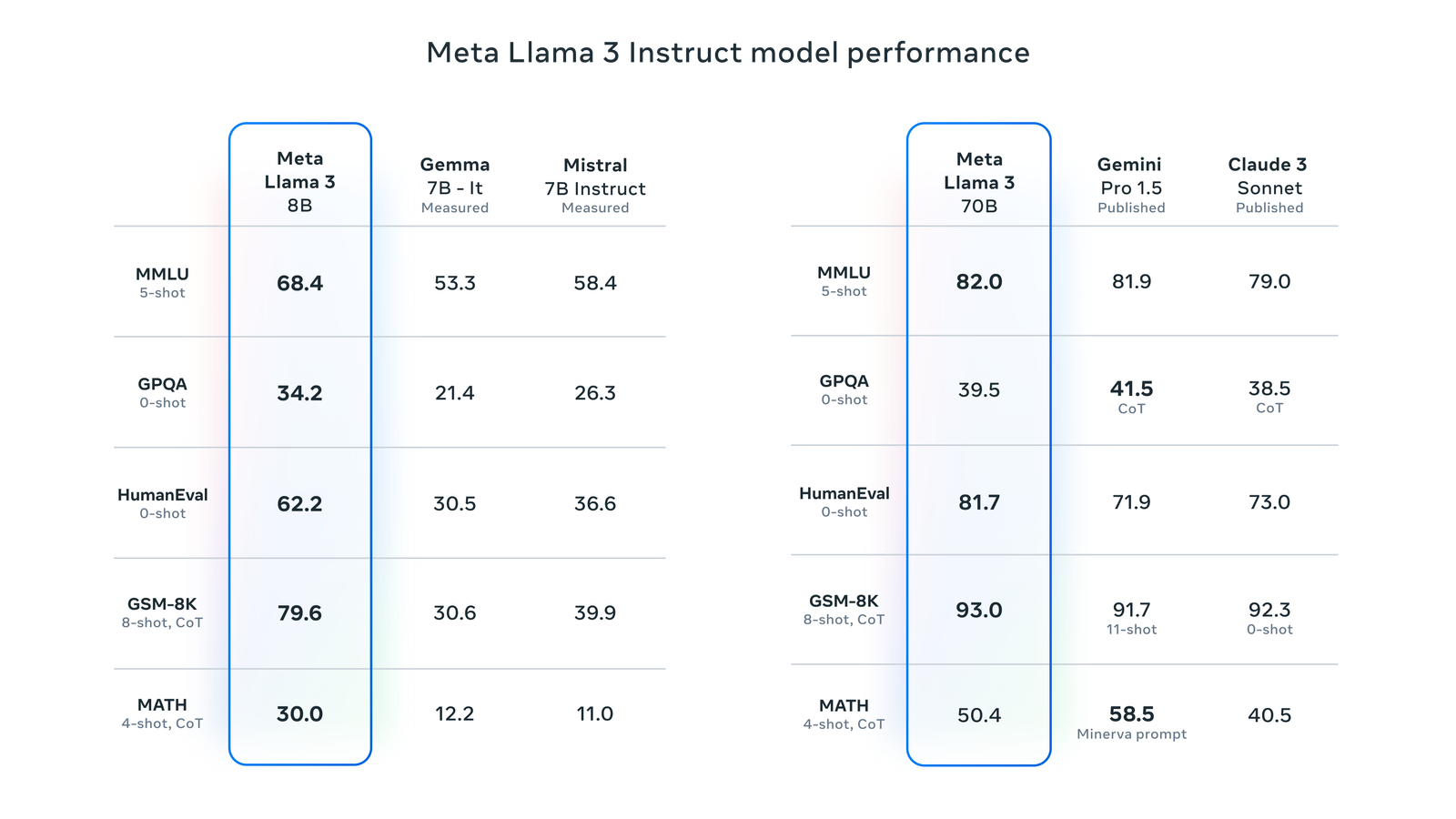

Llama 3的亮点和特性如下:

基于超过15T token训练,大小相当于Llama 2数据集的7倍还多; 训练效率比Llama 2高3倍; 支持8K长文本,改进的tokenizer具有128K token的词汇量,可实现更好的性能; 在大量重要基准测试中均具有最先进性能; 增强推理和代码能力; 安全性有重大突破,带有Llama Guard 2、Code Shield 和 CyberSec Eval 2的新版信任和安全工具,还能比Llama 2有更好“错误拒绝表现”。

四、下载运行模型

ollama run llama3:8b

直接在终端中对话:用 llama3 模型写一个 python函数 或者 回答你的一些知识类问题

根据实际测试,llama3 70B在windows10环境下,基本占用32GB内存,llama3 8B基本占用16GB内存。

建议至少不低于48GB或64GB内存,否则没有足够内存支持运行其他程序。

第三方API调用

API调用默认端口 11434

本地地址参考:127.0.0.1:11434

五、通过seo-tool工具调用

seo-tool工具已集成ollama接口,只要在调用前本地启动模型即可,而且通过seo-tool可以根据标题或关键词批量生成文章,如果本地跑llama3费劲,可以调用 ollama run qwen 来运行阿里的通译千问大模型,生成内容质量还可以而且速度也很快,(题外:生成的文章如果收录不是很好,最好不要用markdown格式和html格式,直接用文本格式)